14/03/2023

Descubren limitaciones fundamentales en el aprendizaje automático de modelos matemáticos

Un estudio impulsado por el grupo de investigación SeesLab de la URV demuestra por primera vez que los algoritmos de aprendizaje automático no siempre logran encontrar modelos interpretables a partir de datos

Un estudio impulsado por el grupo de investigación SeesLab de la URV demuestra por primera vez que los algoritmos de aprendizaje automático no siempre logran encontrar modelos interpretables a partir de datos

El aprendizaje automático está detrás de muchas de las decisiones que se toman en el día a día. La aparición de anuncios personalizados en Internet, la recomendación de contactos y contenidos en las redes sociales, o las estimaciones de la probabilidad de que un medicamento o un tratamiento funcione en determinados pacientes son algunos ejemplos. Esta rama de la inteligencia artificial se basa en el desarrollo de modelos capaces de procesar grandes cantidades de datos, aprender de forma automática e identificar patrones complejos que permitan realizar predicciones. Pero debido a la complejidad y elevado número de parámetros de estos modelos, cuando un algoritmo de aprendizaje automático funciona mal o se detecta un comportamiento erróneo, a menudo es imposible identificar el motivo. De hecho, incluso cuando funcionan como se espera, es difícil entender por qué.

Una alternativa a estos modelos de “caja negra”, cuyo comportamiento es difícil o imposible de controlar, es utilizar el aprendizaje automático para desarrollar modelos matemáticos interpretables. Esta alternativa cobra cada vez mayor relevancia entre la comunidad científica. Sin embargo, ahora un equipo investigador del grupo de SEES Lab de la Universitat Rovira i Virgili ha confirmado, en un estudio publicado en la revista Nature Communications, que en algunas ocasiones nunca se podrán identificar modelos interpretables a partir sólo de datos.

Los modelos matemáticos interpretables no son ninguna novedad. Durante siglos y hasta el día de hoy, la comunidad científica ha descrito los fenómenos naturales mediante modelos matemáticos relativamente simples, como la ley de la gravitación de Newton, por ejemplo. A veces se llegaba a estos modelos de forma deductiva, partiendo de consideraciones fundamentales. Otras, las más frecuentes, la forma de conseguir estos modelos era de forma inductiva, a partir de datos.

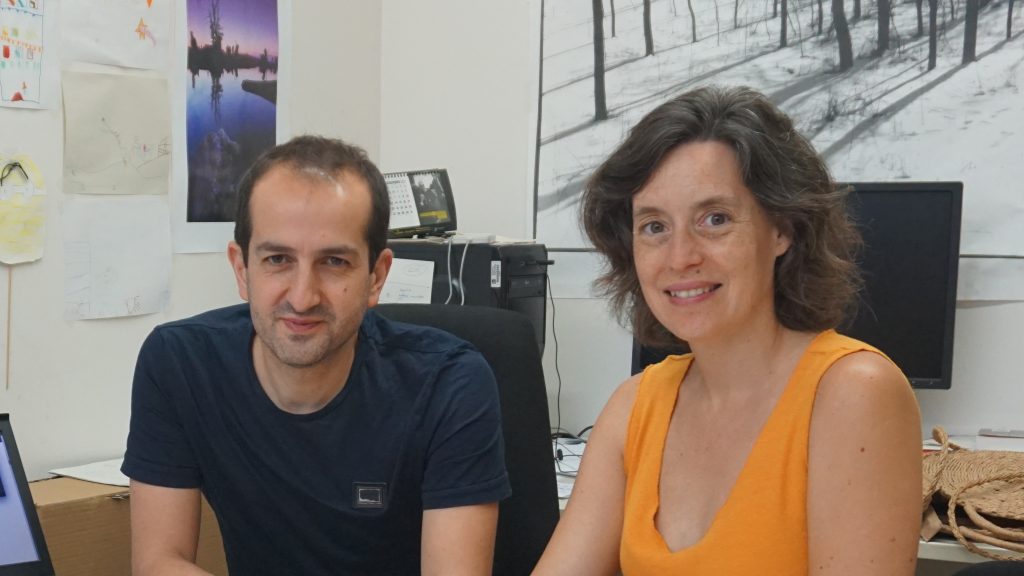

Actualmente, con la gran cantidad de datos disponibles para cualquier tipo de sistema, los modelos interpretables se pueden identificar también mediante el aprendizaje automático. De hecho, el propio equipo investigador diseñó en 2020 un “robot científico”, es decir, un algoritmo capaz de identificar automáticamente modelos matemáticos que, además de mejorar la fiabilidad de sus predicciones, aportan información para comprender los datos, al igual que un científico. Ahora ha dado un paso más con su investigación y ha podido demostrar, gracias precisamente a este «robot científico», que «en ocasiones no es posible averiguar el modelo matemático que realmente rige el comportamiento de un sistema», explica Marta Sales -Pardo, catedrática del Departamento de Ingeniería Química de la URV, que ha participado en la investigación.

La importancia del ruido

Todos los datos que se puedan obtener de un sistema tienen “ruido”, es decir, sufren distorsiones o pequeñas fluctuaciones, que serán diferentes cada vez que se mida. Si los datos tienen poco ruido, un robot científico identificará un modelo claro que, puede demostrarse, es el modelo correcto para los datos. Pero cuanto mayor sea esta variabilidad, más difícil es descubrir el modelo correcto, ya que el algoritmo puede dar como resultado más de un modelo que podría ajustarse bien a los datos. «Cuando esto ocurre hablamos de incertidumbre del modelo, ya que no podemos estar seguros de cuál es el correcto», explica Roger Guimerà, investigador ICREA del mismo grupo de investigación.

Ante esta incertidumbre la clave es utilizar un enfoque riguroso, llamado bayesiano, que consiste en utilizar la teoría de la probabilidad sin aproximaciones. “Nuestro estudio confirma que existe un nivel de ruido a partir del cual ningún mecanismo conseguirá descubrir el modelo correcto. Es una cuestión de teoría de probabilidad: muchos modelos son igual de buenos para los datos, y no podremos saber cuál es el correcto”, concluye el investigador. Por ejemplo, si los termómetros para medir temperatura atmosférica tuvieran errores de lectura de más/menos 20 grados centígrados, sería imposible desarrollar buenos modelos meteorológicos, y un modelo de predicción que dijera que siempre estamos a 10 grados (más/menos 20) sería tan «bueno» como un modelo más detallado que prevé subidas y bajadas de la temperatura.

Los resultados de este estudio desmontan la idea que hasta ahora se tenía de que a partir de los datos siempre es posible encontrar el modelo matemático que los describe. Ahora se demuestra que si no se tienen suficientes datos o éstos tienen demasiado ruido esto será imposible, incluso cuando este modelo correcto sea sencillo. «Estamos ante una limitación fundamental del aprendizaje automático: los datos no tienen por qué ser suficientes para ver lo que está pasando en un sistema concreto», concluye el investigador.

Referencia bibliográfica: Fundamental limits to learning closed-form mathematical models from data. Oscar Fajardo-Fontiveros, Ignasi Reichardt, Harry R. De Los Ríos, Jordi Duch, Marta Sales-Pardo & Roger Guimerà. Nature Communications volume 14, Article number: 1043 (2023). DOI: https://doi.org/10.1038/s41467-023-36657-z