14/03/2023

Descobreixen limitacions fonamentals en l’aprenentatge automàtic de models matemàtics

Un estudi impulsat pel grup de recerca SeesLab de la URV demostra per primera vegada que els algoritmes d’aprenentatge automàtic no sempre aconsegueixen trobar models interpretables a partir de dades

Un estudi impulsat pel grup de recerca SeesLab de la URV demostra per primera vegada que els algoritmes d’aprenentatge automàtic no sempre aconsegueixen trobar models interpretables a partir de dades

L’aprenentatge automàtic està darrere de moltes de les decisions que es prenen en el dia a dia. L’aparició d’anuncis personalitzats a Internet, la recomanació de contactes i continguts a les xarxes socials o les estimacions de la probabilitat de què un medicament o un tractament funcionin en determinats pacients en són alguns exemples. Aquesta branca de la intel·ligència artificial es basa en el desenvolupament de models capaços de processar grans quantitats de dades, aprendre de forma automàtica i identificar patrons complexos que permetin fer prediccions. Però degut a la complexitat i l’elevat número de paràmetres d’aquests models, quan un algorisme d’aprenentatge automàtic funciona malament o se’n detecta un comportament erroni, sovint és impossible identificar-ne el motiu. De fet, fins i tot quan funcionen com s’espera, és difícil entendre per què.

Una alternativa a aquests models de “caixa negra”, el comportament dels quals és difícil o impossible de controlar, és fer servir aprenentatge automàtic per desenvolupar models matemàtics interpretables. Aquesta alternativa pren cada cop més rellevància entre la comunitat científica. Ara, però, un equip investigador del grup de recerca SEES Lab de la Universitat Rovira i Virgili ha confirmat, en un estudi publicat a la revista Nature Communications que en algunes ocasions no es podran mai identificar models interpretables a partir només de dades.

Els models matemàtics interpretables no són cap novetat. Durant segles i fins a dia d’avui, la comunitat científica ha descrit els fenòmens naturals mitjançant models matemàtics relativament simples, com la llei de la gravitació de Newton, per exemple. De vegades s’arribava a aquests models de manera deductiva, partint de consideracions fonamentals. D’altres, les més freqüents, la manera d’aconseguir aquests models era de forma inductiva, a partir de dades.

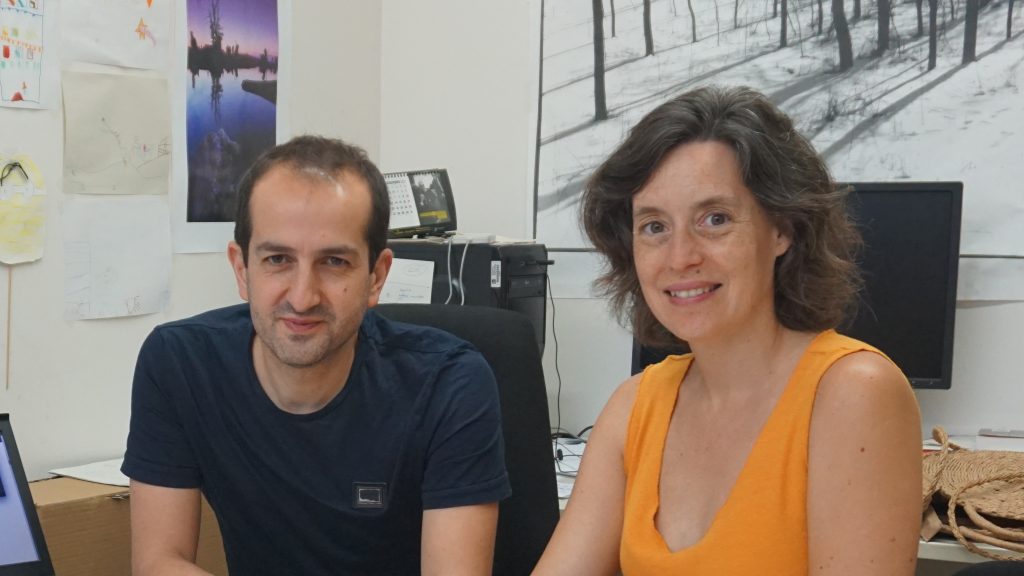

Actualment, amb la gran quantitat de dades disponibles per a qualsevol tipus de sistema, els models interpretables es poden identificar també mitjançant l’aprenentatge automàtic. De fet, el mateix equip investigador de la URV va dissenyar el 2020 un “robot científic”, és a dir: un algoritme capaç d’identificar automàticament models matemàtics que, a més de millorar la fiabilitat de les seves prediccions, aporten informació per comprendre les dades, igual que ho faria un científic. Ara, ha fet un pas més amb la seva recerca i ha pogut demostrar, gràcies precisament a aquest “robot científic”, que “en ocasions no és possible esbrinar el model matemàtic que realment regeix el comportament d’un sistema”, explica Marta Sales-Pardo, catedràtica del Departament d’Enginyeria Química de la URV, que ha participat en la recerca.

La importància del soroll

Totes les dades que es puguin obtenir d’un sistema tenen “soroll”, és a dir: pateixen distorsions o petites fluctuacions, que seran diferents cada cop que es mesuri. Si les dades tenen poc soroll, un robot científic identificarà un model clar que, es pot demostrar, és el model correcte per a les dades. Però com més gran sigui aquesta variabilitat, com més soroll tingui, més difícil és descobrir el model correcte, ja que l’algoritme pot donar com a resultat més d’un model que es podria ajustar bé a les dades. “Quan això passa parlem d’incertesa del model, ja que no podem estar segurs de quin és el correcte”, explica Roger Guimerà, investigador ICREA del mateix grup de recerca.

Davant d’aquesta incertesa la clau és utilitzar un enfocament rigorós, anomenat bayesià, que consisteix en fer servir la teoria de la probabilitat sense aproximacions. “El nostre estudi confirma que hi ha un nivell de soroll a partir del qual cap mecanisme aconseguirà descobrir el model correcte. És una qüestió de teoria de probabilitat: molts models són igual de bons per a les dades, i no podrem saber quin és el correcte”, conclou l’investigador. Per exemple, si els termòmetres per mesurar temperatura atmosfèrica tinguessin errors de lectura de més/menys 20 graus centígrads, seria impossible desenvolupar bons models meteorològics, i un model de predicció que digués que sempre estem a 10 graus (més/menys 20) seria tan “bo” com un model més detallat que preveu pujades i baixades de la temperatura.

Els resultats d’aquest estudi desmunten, doncs, la idea que es tenia fins ara de què a partir de les dades sempre és possible trobar el model matemàtic que les descriu. Ara es demostra que si no es tenen prou dades o aquestes tenen massa soroll això serà impossible, fins i tot quan aquest model correcte sigui senzill. “Estem davant d’una limitació fonamental de l’aprenentatge automàtic: les dades no tenen per què ser suficients per veure el que està passant en un sistema concret”, conclou l’investigador.

Referència bibliogràfica: Fundamental limits to learning closed-form mathematical models from data. Oscar Fajardo-Fontiveros, Ignasi Reichardt, Harry R. De Los Ríos, Jordi Duch, Marta Sales-Pardo & Roger Guimerà. Nature Communications volume 14, Article number: 1043 (2023). DOI: https://doi.org/10.1038/s41467-023-36657-z

Més notícies de: SEES:lab